Homem Ă© hospitalizado com alucinaçÔes apĂłs seguir recomendação do ChatGPT: um alerta sobre o uso da inteligĂȘncia artificial

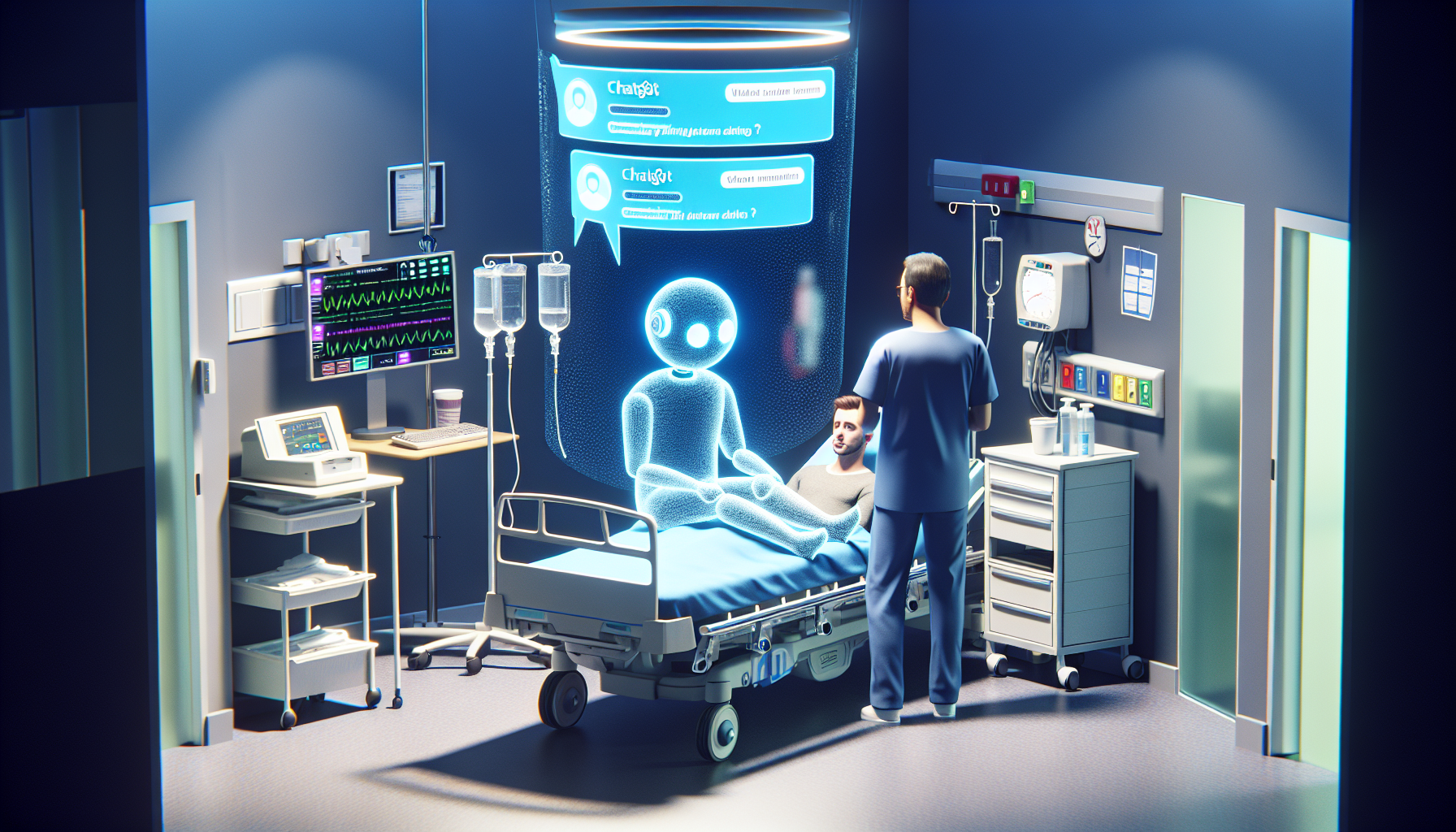

Nos Ășltimos anos, o avanço da inteligĂȘncia artificial tem revolucionado a forma como buscamos informaçÔes e tomamos decisĂ”es no nosso dia a dia. Ferramentas como o ChatGPT, desenvolvidas para proporcionar respostas rĂĄpidas, precisas e interativas, ganharam enorme popularidade, sendo utilizadas por milhĂ”es de pessoas ao redor do mundo. Contudo, o caso recente de um homem hospitalizado com alucinaçÔes apĂłs seguir uma recomendação da IA chamou atenção para os riscos potenciais dessa tecnologia e levantou importantes questionamentos sobre os limites de seu uso.

O paciente, cujo nome nĂŁo foi divulgado para preservar sua privacidade, relatou ter buscado auxĂlio no ChatGPT para tratar sintomas leves de ansiedade. ApĂłs receber sugestĂ”es que incluĂam prĂĄticas nĂŁo supervisionadas de meditação profunda e o uso de determinadas substĂąncias naturais, ele decidiu seguir as orientaçÔes sem consultar um profissional de saĂșde. Em poucos dias, começaram as manifestaçÔes intensas de alucinaçÔes, que o levaram a buscar atendimento emergencial.

Contexto e origem do problemaO relato ilustra um problema crescente: a confiança excessiva em sistemas automatizados sem o devido discernimento crĂtico. O ChatGPT e outras ferramentas similares sĂŁo baseadas em modelos de linguagem treinados em gigantescos volumes de dados textuais. Embora sejam capazes de simular conversas humanas e apresentar informaçÔes detalhadas, elas nĂŁo substituem o julgamento clĂnico de um especialista.

AlĂ©m disso, a IA nĂŁo possui consciĂȘncia ou entendimento real do conteĂșdo que gera. Isso significa que, por vezes, pode produzir recomendaçÔes inadequadas, imprecisas ou atĂ© potencialmente prejudiciais, especialmente quando temas sensĂveis Ă saĂșde mental ou fĂsica sĂŁo tratados sem supervisĂŁo adequada. O caso do homem hospitalizado Ă© um alerta para que os usuĂĄrios tenham cautela e se informem sobre os riscos antes de implementar sugestĂ”es sugeridas por essas plataformas.

Por que isso aconteceu?Esses fatores, combinados, aumentam o risco de complicaçÔes, especialmente em situaçÔes que envolvem saĂșde mental, onde alucinaçÔes e outras alteraçÔes do estado de consciĂȘncia podem ser sintomas graves demandando cuidado imediato.

ReflexĂ”es sobre o uso responsĂĄvel da inteligĂȘncia artificialEmbora ferramentas como o ChatGPT tragam inĂșmeros benefĂcios, como acesso instantĂąneo a informaçÔes e auxĂlio em tarefas cotidianas, Ă© fundamental estabelecer limites claros para seu uso. As inteligĂȘncias artificiais atualmente nĂŁo substituem profissionais qualificados e nĂŁo devem ser consideradas fontes definitivas para diagnĂłsticos ou tratamentos mĂ©dicos.

Especialistas recomendam que o usuĂĄrio sempre utilize essas tecnologias como um complemento e nĂŁo como substituto do conhecimento profissional. Em casos de sintomas persistentes ou graves, a busca por atendimento mĂ©dico qualificado continua sendo imprescindĂvel.

OrientaçÔes para o usuĂĄrioO incidente com o homem hospitalizado deve servir para que toda a sociedade reflita sobre como a inteligĂȘncia artificial estĂĄ sendo incorporada em nossas vidas e a importĂąncia de usĂĄ-la com responsabilidade, sobretudo em ĂĄreas sensĂveis como a saĂșde. A tecnologia Ă© uma poderosa aliada, mas somente se aliada ao conhecimento, prudĂȘncia e supervisĂŁo humana adequada.

Em resumo, o avanço da inteligĂȘncia artificial oferece benefĂcios incrĂveis, mas tambĂ©m impĂ”e desafios que exigem cuidado e reflexĂŁo. O caso desse homem que sofreu alucinaçÔes mostra que o uso indiscriminado e sem filtro das recomendaçÔes digitais pode acarretar sĂ©rios problemas. Ă fundamental que usuĂĄrios, desenvolvedores e reguladores trabalhem juntos para garantir que essas ferramentas sejam cada vez mais seguras, confiĂĄveis e que jamais substituam o atendimento humano especializado.

Assim, a melhor forma de aproveitar a inteligĂȘncia artificial Ă© entendendo suas limitaçÔes e potencialidades, utilizando-a como um instrumento de apoio e jamais como fonte Ășnica de decisĂ”es, especialmente quando estĂĄ em jogo a saĂșde mental e fĂsica das pessoas.