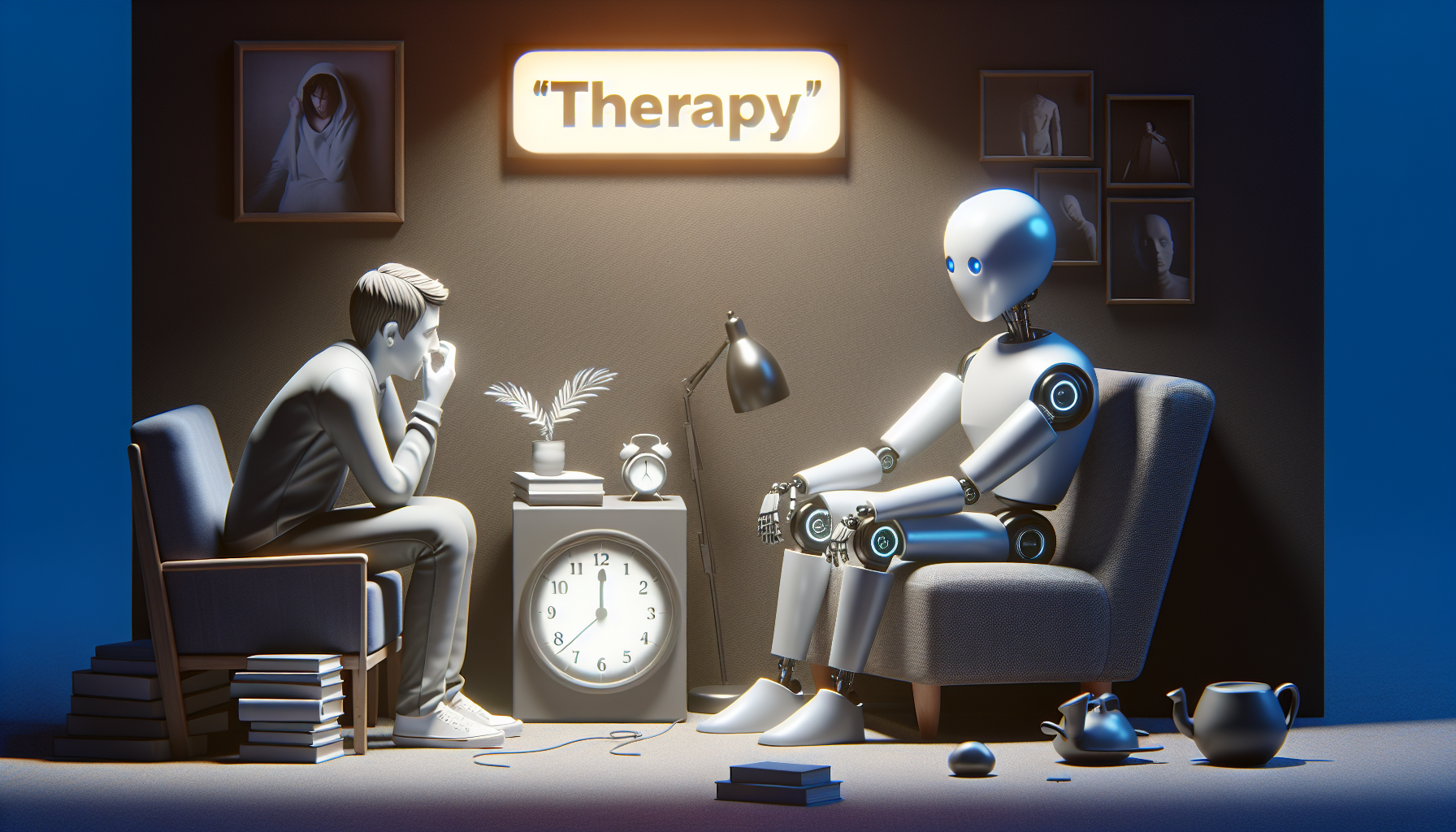

Os Perigos da вҖңTerapiaвҖқ pelo ChatGPT: Uma ExperiГӘncia Real e ReflexГөes Cruciais

Nos Гәltimos anos, a inteligГӘncia artificial tem avanГ§ado de maneira impressionante, transformando diversos setores da sociedade. Entre essas inovaГ§Гөes, destacam-se os chatbots baseados em IA, como o ChatGPT, que oferecem suporte para os mais variados assuntos, desde perguntas simples atГ© conversas mais complexas. Contudo, hГЎ um campo em que a aplicação dessas tecnologias deve ser abordada com extrema cautela: a saГәde mental. Recentemente, resolvi testar por conta prГіpria a chamada вҖңterapiaвҖқ pelo ChatGPT, motivado pela curiosidade e pelo crescente interesse popular em buscar ajuda em plataformas digitais. O que encontrei foi, no mГӯnimo, uma experiГӘncia preocupante, que levanta questГөes importantes sobre os riscos e limites da automedicação emocional feita por algoritmos.

O contexto da minha busca

Vivemos em um mundo de constantes pressГөes, onde muitas pessoas enfrentam ansiedade, estresse e outros transtornos emocionais. A demanda por atendimento psicolГіgico cresceu exponencialmente, mas a oferta ainda Г© insuficiente, o que impulsiona a procura por alternativas, especialmente gratuitas e de fГЎcil acesso. Гү nesse cenГЎrio que a вҖңterapiaвҖқ pelo ChatGPT ganhou notoriedade, com usuГЎrios relatando sessГөes que simulam diГЎlogos terapГӘuticos. No entanto, serГЎ que essa ferramenta estГЎ preparada para lidar com as complexidades humanas e as sutilezas da mente?

Minha experiГӘncia com o ChatGPT como вҖңterapeutaвҖқ

Ao iniciar a conversa, procurei criar um ambiente propГӯcio, relatando minhas questГөes emocionais e buscando respostas que me ajudassem a refletir e encontrar alternativas para meus problemas. De inГӯcio, as respostas foram atenciosas e fundamentadas em terapias tradicionais, como a terapia cognitivo-comportamental, que guia o paciente a identificar e reformular pensamentos negativos. Por algum tempo, o diГЎlogo parecia uma conversa produtiva, o que me trouxe certa sensação de conforto e esperanГ§a.

No entanto, conforme avancei na interação, percebi que o ChatGPT se mostrava incapaz de captar nuances do meu estado emocional, pois suas respostas passaram a ser mais genГ©ricas e repetitivas. Frases como вҖңTente focar no presenteвҖқ ou вҖңLembre-se de cuidar de si mesmoвҖқ perderam a forГ§a sem um direcionamento mais profundo ou um acompanhamento personalizado.

Os riscos da automedicação emocional automatizada

Um ponto crucial que notei durante a вҖңterapiaвҖқ Г© a falta de uma anГЎlise crГӯtica e empatia genuГӯna, elementos indispensГЎveis para uma cura efetiva na ГЎrea da saГәde mental. Embora o ChatGPT utilize avanГ§ados modelos de linguagem para simular conversas, ele nГЈo possui sentimentos ou experiГӘncias humanas, o que limita sua capacidade de interpretar contextos complexos ou perceber sinais de alerta diante de situaГ§Гөes graves, como pensamentos suicidas ou transtornos severos.

Aspectos Г©ticos e limitaГ§Гөes legais

Outro aspecto que merece atenção Г© a responsabilidade Г©tica. Profissionais da psicologia passam anos em formação e supervisionamento, adquirindo habilidades que nГЈo podem ser simplesmente substituГӯdas por uma inteligГӘncia artificial. Quando um indivГӯduo busca вҖңterapiaвҖқ em um chatbot, ele pode estar desinformado sobre os limites da ferramenta e os riscos que corre ao confiar cegamente no atendimento digital. AlГ©m disso, a regulamentação sobre o uso de IA em saГәde mental ainda Г© incipiente, o que gera um vГЎcuo que pode ser prejudicial.

Por que o ChatGPT nГЈo deve ser um substituto da terapia profissional

- Falta de empatia real: A IA nГЈo sente, nГЈo compreende emoГ§Гөes humanas com profundidade.

- Respostas padronizadas: Sua programação inevitavelmente recorre a respostas genГ©ricas para situaГ§Гөes complexas.

- Incapacidade de diagnГіstico: NГЈo pode substituir o diagnГіstico clГӯnico por profissionais habilitados.

- Risco de agravamento: Em casos de crises emocionais, a ausГӘncia de intervenção humana pode ser fatal.

Como utilizar o ChatGPT de forma responsГЎvel para apoio emocional

Apesar das limitaГ§Гөes, acredito que o ChatGPT pode ser uma ferramenta complementar, desde que utilizada com consciГӘncia e sem substituir sessГөes de terapia presencial ou online com psicГіlogos certificados. Veja algumas recomendaГ§Гөes para quem busca apoio emocional na inteligГӘncia artificial:

- NГЈo utilizar como Гәnica fonte de ajuda: Procure sempre um profissional ao sentir sofrimento persistente.

- Evite confidenciar cenГЎrios de risco: Se houver pensamentos suicidas, procure imediatamente ajuda humana e especializada.

- Utilize para reflexГЈo e informaГ§Гөes bГЎsicas: Quando precisar esclarecer dГәvidas sobre saГәde mental ou buscar exercГӯcios de relaxamento.

- Mantenha a privacidade: Evite compartilhar dados pessoais sensГӯveis nas plataformas digitais.

ConclusГЈo: o futuro da terapia digital deve ser guiado pela Г©tica e responsabilidade

Minha experiГӘncia com a вҖңterapiaвҖқ pelo ChatGPT reforГ§ou a importГўncia de entender que, por mais sofisticadas que sejam as tecnologias, elas nГЈo podem substituir o olhar atento e humano dos profissionais de saГәde mental. Гү fundamental expandir o acesso a terapias qualificadas e investir na educação para o uso seguro das ferramentas digitais. A inteligГӘncia artificial deve funcionar como aliada, nГЈo substituta, na busca pelo bem-estar emocional.

Por fim, se vocГӘ estГЎ lendo este texto e enfrenta dificuldades emocionais, lembre-se: nГЈo estГЎ sozinho. Buscar ajuda profissional Г© o primeiro passo para uma verdadeira transformação. E usar o ChatGPT como apoio pode ser vГЎlido, desde que com cautela e sabendo seus limites.

Recomenda-se sempre priorizar o cuidado humano, pois a mente Г© delicada demais para experimentos perigosos.