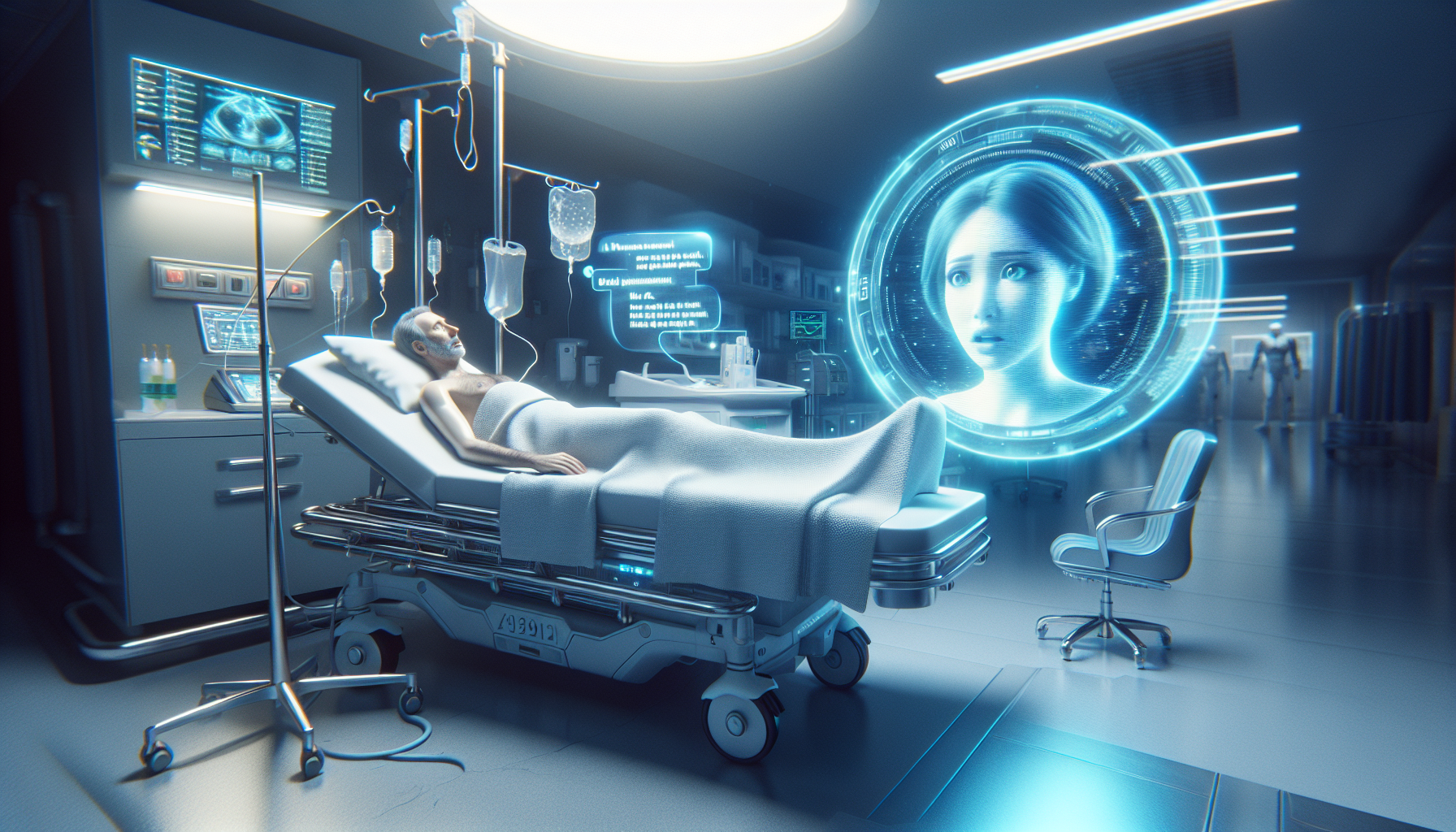

Quando a Inteligência Artificial Vai Além: Homem Hospitalizado Após Seguir Recomendação do ChatGPT

Nos últimos anos, a inteligência artificial (IA) tem se tornado uma ferramenta cada vez mais presente no dia a dia das pessoas. Com a popularização de assistentes virtuais e sistemas baseados em IA, como o ChatGPT, muitos usuários passaram a confiar nessas tecnologias para obter informações, conselhos e soluções rápidas para diversos problemas. No entanto, o uso indiscriminado e sem supervisão adequada dessas plataformas pode acarretar riscos sérios, como evidencia um caso recente que chocou a comunidade médica: a hospitalização de um homem após ele seguir uma recomendação do ChatGPT, que resultou em alucinações severas.

Este episĂłdio levanta uma sĂ©rie de discussões importantes sobre os limites, os riscos e a responsabilidade no uso das inteligĂŞncias artificiais, especialmente em áreas sensĂveis como a saĂşde mental. Neste artigo, vamos explorar esse caso com detalhes, analisar os fatores que contribuĂram para a grave consequĂŞncia e refletir sobre a necessidade de maior supervisĂŁo e regulamentação dessas tecnologias no futuro.

O caso que chamou atençãoTudo começou quando o homem, cujo nome nĂŁo foi divulgado para preservar a privacidade, buscou no ChatGPT orientação para lidar com sintomas de ansiedade e insĂ´nia, que vinha enfrentando há meses. No diálogo, ele solicitou conselhos para melhorar seu estado mental e, recebendo uma resposta aparentemente detalhada, decidiu experimentar uma sĂ©rie de dicas sugeridas pela IA, que incluĂam mudanças de hábitos, tĂ©cnicas de relaxamento e, surpreendentemente, o uso de suplementos naturais que seriam eficazes para seu quadro.

Infelizmente, sem uma avaliação clĂnica adequada e sem acompanhamento mĂ©dico, ele passou a utilizar substâncias indicadas durante várias semanas. Em pouco tempo, começaram a surgir efeitos colaterais graves, como confusĂŁo mental, alucinações visuais e auditivas e um comportamento errático. Sua famĂlia, preocupada, o levou rapidamente a um hospital, onde ele foi internado para tratamento psiquiátrico intensivo.

Como a inteligência artificial pode errarO ChatGPT, desenvolvido pela OpenAI, é um modelo de linguagem treinado para gerar respostas coerentes e contextualizadas com base no que aprende de um vasto conjunto de dados textuais. Contudo, ele não possui a capacidade de realizar diagnósticos médicos ou avaliar individualmente o estado de saúde dos usuários. Sua função é fornecer informações baseadas em padrões encontrados nos dados, mas isso não substitui a análise de profissionais especializados.

No caso do homem hospitalizado, Ă© possĂvel que a IA tenha interpretado erroneamente ou combinado informações disponĂveis sobre suplementos e tĂ©cnicas de saĂşde mental, sem considerar contraindicações, dosagens adequadas ou condições especĂficas do paciente. Isso demonstra uma limitação crĂtica das IAs atuais: a falta de discernimento clĂnico e a incapacidade de alertar para riscos individuais.

Os perigos do autotratamento baseado em IAEmbora a IA possa ser uma fonte valiosa de informação, seu uso como substituto de consulta médica é extremamente perigoso. Algumas das consequências do autotratamento com base em recomendações geradas por IA incluem:

O caso do homem hospitalizado reforça a importância de sempre buscar ajuda mĂ©dica presencial para problemas de saĂşde, especialmente relacionados Ă saĂşde mental, onde o diagnĂłstico e tratamento podem ser muito complexos e sensĂveis.

A responsabilidade dos desenvolvedores e dos usuáriosÉ fundamental que desenvolvedores de IA estejam cientes das limitações de seus sistemas e implementem mecanismos para minimizar riscos, como avisos claros de que a plataforma nĂŁo substitui profissionais de saĂşde. AlĂ©m disso, o avanço da regulamentação Ă© imprescindĂvel para garantir que essas tecnologias sejam usadas com segurança.

Por outro lado, usuários devem entender que, apesar da popularidade e do avanço tecnológico, as IAs são ferramentas auxiliares e não substituem o conhecimento e a experiência de médicos, psicólogos e outros profissionais qualificados. A educação digital é essencial para que a população saiba quando e como utilizar essas ferramentas de forma segura.

Conclusão: O futuro da interação entre humanos e IA na saúdeEste triste incidente serve como um alerta contundente: apesar das inúmeras potencialidades da inteligência artificial para melhorar nossas vidas, o uso indevido ou exagerado pode trazer sérias consequências. A integração responsável da IA na área da saúde deve vir acompanhada de regulamentações eficazes, orientações claras e uma conscientização ampla dos usuários.

É essencial que o pĂşblico em geral saiba que, ao lidar com questões delicadas como a saĂşde mental, o suporte humano, a avaliação clĂnica presencial e a empatia profissional nĂŁo podem ser substituĂdos por algoritmos. A inteligĂŞncia artificial deve ser vista como uma aliada, nĂŁo como uma solução definitiva.

À medida que a tecnologia evolui, todos nós – desenvolvedores, profissionais da saúde, legisladores e usuários – temos o dever de garantir que essa poderosa ferramenta seja usada de forma ética, responsável e segura, para que casos como o do homem hospitalizado sejam evitados no futuro.

Assim, manter o equilĂbrio entre inovação tecnolĂłgica e cuidado humano será o grande desafio das prĂłximas dĂ©cadas e a chave para um futuro mais saudável e consciente.